En el apasionante mundo de la inteligencia artificial, hay un tipo de modelo que destaca por su capacidad para procesar y comprender secuencias de datos: las redes neuronales recurrentes. Hoy, exploraremos en profundidad qué son las redes neuronales recurrentes y cómo se utilizan en diversas aplicaciones.

¿Qué son las Redes Neuronales Recurrentes?

Las redes neuronales recurrentes (RNN) son un tipo de redes neuronales artificiales especializadas en el procesamiento de datos secuenciales, como series temporales o datos textuales.

A diferencia de las redes neuronales tradicionales, las RNN presentan conexiones recurrentes que les permiten mantener un estado interno y memorizar información sobre entradas previas. Esto las hace ideales para tareas que requieren entender el contexto como traducción, reconocimiento del habla o análisis de sentimiento.

¿Cómo funcionan las Redes Neuronales Recurrentes?

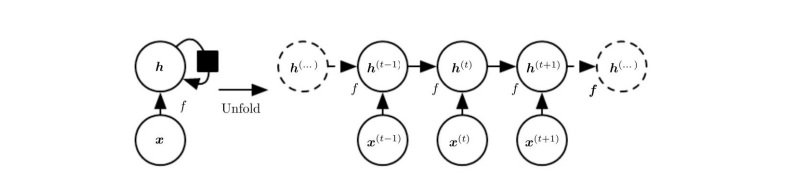

Las Redes Neuronales Recurrentes procesan una secuencia paso a paso. En cada paso, reciben un elemento de entrada y su estado anterior. A partir de esto, calculan un nuevo estado y una salida.

El estado actúa como una memoria que captura la información relevante de los elementos previos. Esta memoria se actualiza continuamente a medida que la red procesa nuevos datos.

Tipos de RNN

Existen varios tipos de Redes Neuronales Recurrentes que se adaptan a distintos casos de uso:

- RNN unidireccionales: Solo tienen en cuenta el contexto previo.

- RNN bidireccionales: Procesan la secuencia en ambos sentidos, teniendo en cuenta contexto futuro y pasado.

- LSTM: Resuelven problemas de largo plazo mediante una arquitectura más compleja.

- GRU: Similar a LSTM pero más simple y liviana.

- RNN con atención: Utilizan mecanismos de atención para enfocarse en partes relevantes.

Cada una presenta ventajas para ciertas aplicaciones. Por ejemplo, las LSTM son ideales para dependencias a largo plazo mientras que las GRU requieren menos recursos.

Aplicaciones de las Redes Neuronales Recurrentes

Las RNN tienen una amplia gama de aplicaciones dada su especialización en datos secuenciales:

- Procesamiento de Lenguaje Natural (PLN): traducción automática, resumen de textos, generación de texto, etc.

- Reconocimiento automático del habla: transcribir audio a texto.

- Análisis de sentimientos: identificar la emoción de un texto.

- Generación de subtítulos: crear descripciones de imágenes y videos.

- Predicción de series temporales: pronósticos meteorológicos, precios de acciones, etc.

- Reconocimiento de escritura: transcribir texto escrito a mano.

- Generación de música: componer música original.

Las RNN han revolucionado el procesamiento de secuencias, impulsando avances en estas áreas.

Comparación con otros tipos de redes neuronales

Las principales diferencias de las RNN con otros tipos de redes neuronales son:

- Frente a las redes feedforward: las RNN tienen conexiones recurrentes, memoria interna y pueden mapear secuencias de distinta longitud.

- Frente a las CNN: las RNN se especializan en datos secuenciales, mientras que las redes neuronales convolucionales en datos multidimensionales como imágenes.

- Frente a redes neuronales profundas: las RNN introducen la noción de tiempo mediante sus bucles recurrentes.

La memoria interna de las RNN es la clave que les permite procesar secuencias de manera eficiente, capturando dependencias y contexto. Esto las diferencia de otros enfoques.

Preguntas frecuentes

¿Cuáles son características de la arquitectura de una red neuronal recurrente RNN?

Sus conexiones recurrentes que capturan dependencias temporales. Su topología secuencial que procesa un elemento a la vez. Su estado interno que hace de memoria.

¿Qué diferencias existen entre las redes neuronales Convolucionales recurrentes y multicapa?

Las RNN se especializan en secuencias, las CNN en datos multidimensionales y las multicapa no modelan dependencias temporales.